“20년 클라우드·인프라 경험, AI 시대 경쟁력 핵심” [AWS 리인벤트 2025]

||2025.12.05

||2025.12.05

“인공지능(AI) 워크로드의 수요가 전례 없이 증가하고 있다. 하지만 AI 시대에 중요한 가치는 지난 20년간 클라우드 시대와도 일맥상통한다. AWS는 지금까지의 혁신 기술을 AI에 적용해 고객들에 가치를 제공하고자 한다.”

피터 데산티스(Peter Desantis) AWS 유틸리티 컴퓨팅 수석부사장은 12월 1일부터 5일까지(현지시각) 미국 네바다주 라스베이거스 열린 ‘AWS 리인벤트 2025(AWS re:Invent 2025)’ 행사의 기조연설에서 AI 시대를 위한 AWS의 인프라와 솔루션을 소개하며 이와 같이 밝혔다.

AWS는 이번 ‘AWS 리인벤트 2025’서 인프라 부문의 다양한 신제품을 소개했다. 하드웨어 수준에서는 이전 대비 코어 수가 두 배 늘어나며 성능이 높아진 ‘그래비톤5’와 칩당 연산 성능이 두 배 가량 높아진 ‘트레이니움3’ 칩이 소개됐다. 또한AI워크로드를 효율적으로 수행하기 위한 아마존 베드록, 람다 플랫폼의 AI 최적화 업데이트와 벡터 데이터베이스를 쉽고 효율적으로 다룰 수 있는 벡터 서치 기능 통합, ‘아마존 S3 벡터’도 소개됐다.

코어 수 두 배 늘어난 ‘그래비톤5’, 이전 세대 대비 큰 성능 향상

피터 데산티스(Peter Desantis) AWS 유틸리티 컴퓨팅 수석부사장은 “AI 워크로드는 전례없을 정도로 빠르게 증가하고 있다”며 “지금까지의 혁신 기술을 AI에 적용해 유연성을 제공하고자 하는 것이 목표”라고 밝혔다. 이어 “AI 애플리케이션은 정말 비싸고, 방대한 추론을 실행하려면 많은 비용이 든다. AWS도 높은 AI 수요를 위한 확장에 막대한 투자를 하고 있지만, 비용을 낮추기 위한 다른 노력들도 병행하고 있다”고 덧붙였다.

AWS의 성공에 중요한 역할을 했던, 기업들이 온프레미스 환경보다 더 빨리 최신 기술을 사용하고 가치를 더 빠르게 창출할 수 있게 했던 ‘민첩성’은 AI로의 전환에도 중요한 요소로 꼽힌다. 피터 데산티스 수석부사장은 “AWS는 매년 새로운 서비스와 역량을 선보이며 고객들의 워크로드에 적절한 도구들을 제공하고 있다”며 “이러한 구성요소의 힘은 에이전트와 만나면서 증폭된다”고 밝혔다.

데이브 브라운(Dave Brown) AWS 컴퓨트∙머신러닝 서비스 부사장은 “그래비톤(Graviton) 시리즈 프로세서는 범용 클라우드 인프라에 대한 투자의 일환”이라며 “그래비톤은 다양한 워크로드에서 향상된 성능과 효율을 제공하며, 주요 소프트웨어 개발사(ISV) 파트너들과 함께 최적화했다”고 소개했다.

기존 ‘그래비톤4’는 설계 단계에서 캐시 적중률 문제를 우선적으로 고려해, 그래비톤3 대비 코어 수는 50% 늘리고 L2 캐시를 두 배, L3 캐시는 12% 확장한 구성을 사용했다. 하지만 이 과정에서 코어 수 증가 대비 L3 캐시 증가 폭이 작아서 코어당 할당될 수 있는 평균 L3 캐시량이 크게 줄었고, 이 부분이 특정 워크로드에서 성능에 상당한 영향을 줬다. 또한 멀티 프로세서 구성까지 사용하는 다코어 활용 환경에서 프로세서를 넘어가는 과정에서의 지연시간 문제도 제기됐다.

‘그래비톤5’는 이러한 문제들을 해결하기 위해 최대 192코어로 코어 수가 두 배 늘어났다. 이를 통해 기존에는 2개 프로세서로 처리할 워크로드를 한 개로 처리할 수 있어, 멀티 프로세서 구성에서의 프로세서간 연결 지연시간에 대한 문제를 줄였다. L3 캐시 또한 이전 세대 대비 5.3배 증가했다. 코어 수가 두 배 늘었지만 L3 캐시가 5.3배 증가하면서 코어당 사용가능한 L3 용량은 2.6배 늘었다. 이렇게 캐시 용량이 늘어나면서 프로세서의 메모리 접근을 줄이고 전반적인 성능을 올렸다.

이 ‘그래비톤5’는 ‘아마존 EC2 M9g 인스턴스’로 제공된다. 이 ‘M9g’는 네트워크 대역폭도 최대 15%, 아마존 EBS(Elastic Block Store) 대역폭은 최대 20% 향상됐다. 이전 세대 M8g 대비 25%정도 높은 성능을 제공하며, 특히 SAP 애플리케이션의 경우 한 세대 만에 60%의 성능 향상을 제공하는 것으로 소개됐다. 한편, ‘그래비톤5’는 최신 3나노미터(nm) 공정으로 만들어졌고 AWS의 사용 사례에 맞춰 최적화됐으며, 시스템 디자인에서는 쿨러와 실리콘 다이가 직접 접촉하는 ‘베어 다이 냉각(bare-die cooling)’ 구조를 사용했다.

파얌 미라시디(Payam Mirrashidi) 애플 클라우드 시스템 및 플랫폼 부사장은 이 자리에서 “애플의 서비스는 스위프트(Swift) 언어로 만들어져 AWS의 그래비톤 기반 인프라에서 운영돼고 있다”고 소개했다. 이어 “스위프트를 기반으로 디바이스에서 서버까지 단일 코드베이스를 유지할 수 있었다”며 “그래비톤에서 직접 수행되는 스위프트 기반 앱으로 40% 성능 향상과 30% 비용 절감 효과를 얻었다”고 언급했다.

AI 시대에 맞춘 ‘서버리스’의 변화

클라우드 컴퓨팅은 이전의 ‘온프레미스’ 방식 컴퓨팅과 차별화되는 유연성과 민첩함을 선보이며 고객들이 비즈니스 차별화에 더 집중할 수 있게 했다. 그리고 이러한 콘셉트가 극대화된 것이 사용자가 서버 환경을 구성하지 않고도 코드만으로 애플리케이션을 구동할 수 있는 ‘서버리스(Serverless)’ 아키텍처였다. 데이브 브라운 부사장은 이에 대해 “서버리스는 서버의 관리에 대한 경험을 없애는 것”이라 소개했다. 이 ‘서버리스’는 AWS의 ‘람다’ 서비스로 선보인 바 있다.

서버리스 환경이 다양한 영역에 활용되면서 서버리스 또한 새로운 단계로의 ‘특이점’을 맞았다. EC2가 가지는 인스턴스 구성 선택과 람다의 서버리스 경험을 함께 원하는 요구가 등장한 것이다. AWS는 이에 대해 ‘AWS 람다 매니지드 인스턴스(AWS Lambda Managed Instances)’를 소개했다. 이 ‘람다 매니지드 인스턴스’는 EC2처럼 인스턴스 유형을 선택할 수 있으면서 기존 람다 함수를 그대로 사용할 수 있다. 데이브 브라운 부사장은 “이는 서버리스를 벗어난 것이 아니라 확장한 것”이라고 언급했다.

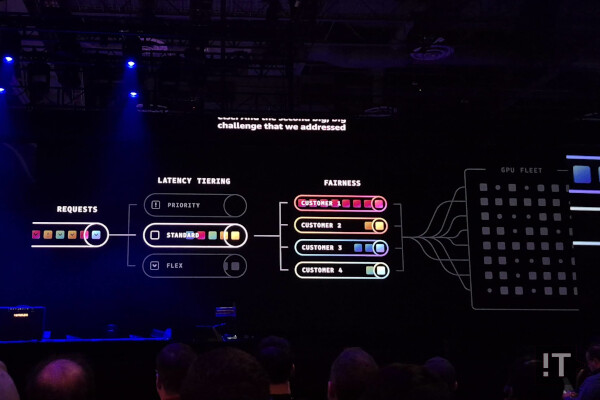

AI 추론 워크로드에서 인프라를 효율적으로 활용하는 것도 쉽지 않은 일이었다. 현재의 AI 파이프라인은 프롬프트에서 응답까지 여러 단계를 거치고, CPU와 GPU, 메모리, 지연시간 등 다양한 요구가 단계별로 달라졌기 때문이다. 그리고 여러 사용자들의 수많은 워크로드가 모이면 이를 최적화하기는 더 까다로워지고, 실시간으로 조정이 가능한 아키텍처가 필요해졌다.

AWS는 이러한 AI 추론 워크로드에서의 최적화를 위해 ‘아마존 베드록 프로젝트 맨틀(Project Mantle)’을 소개했다. 이 ‘프로젝트 멘틀’은 베드록의 워크로드 배치에서 좀 더 다양한 기준으로 작업을 배치하는 고도화된 로드 밸런서의 개념이다. 여기서는 사용자가 지연시간 목표를 직접 설정할 수 있고, 각 사용자간 확장 가능한 전용 대기열도 제공된다. 이러한 구성을 통해 베드록 서비스는 자원을 더 효율적으로 사용하면서, 특정 고객의 사용량에 따른 다른 사용자들의 성능 영향 문제도 해결할 수 있다고 제시했다.

이 외에도 베드록에는 파인튜닝 등 장시간 실행되는 복잡한 워크로드에서의 신뢰성과 효율성, 복원력을 제공하는 ‘저널(Journal)’ 기능이나 보안에서 암호화 상태를 유지하면서 워크로드를 수행하는 ‘기밀 컴퓨팅(Confidential Computing)’ 기능, 람다 함수 지원이나 접근제어, 클라우드워치 등이 추가됐다고 소개됐다. 데이브 브라운 부사장은 “추론은 새로운 영역의 컴퓨팅이 됐다. 베드록은 이러한 워크로드를 안정적이고 효율적이며 안전하게 실행할 수 있는 기반을 제공한다”고 밝혔다.

AI 위한 통합 데이터 플랫폼 만드는 방향성

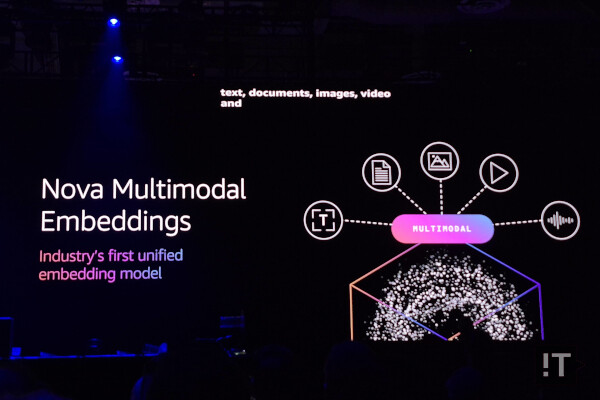

AI 시대에 중요한 요소로 데이터와 이를 사용할 수 있는 플랫폼이 주목받고 있다. 특히 AI에서는 데이터의 검색을 위한 ‘벡터(Vector)’가 중요하게 다뤄진다. 하지만 AI를 위해 모든 데이터를 벡터 데이터베이스로 만드는 데는 난관이 있다. 바로 기존 임베딩 모델들은 각 모델마다 특정 데이터 형식에 최적화돼 있어, 여러 데이터 형식을 사용하고자 하면 각 임베딩 모델간 호환성이 현실적인 문제가 된다.

AWS는 이런 문제를 해결하기 위해 ‘노바 멀티모달 임베딩(Nova Multimodal Embeddings)’ 모델을 제시했다. 이 모델은 단일 모델에서 다양한 형식의 데이터를 다룰 수 있어 여러 임베딩 모델간 호환성 문제를 근본적으로 피할 수 있다. 이를 통해 모든 데이터에 대해 통합된 이해가 가능하고, 정확도 또한 업계 최고 수준이라고 언급됐다. 이 외에도, AWS는 벡터 검색 기능을 주요 제품들에 통합해, 새로운 벡터 데이터베이스를 도입하고 배울 필요 없이 기존 제품에서 자연스럽게 확장할 수 있게 했다고 덧붙였다.

벡터 데이터베이스의 접근성을 높이기 위한 또 다른 방향성은 ‘아마존 S3 벡터(Amazon S3 Vector)’다. 오브젝트 스토리지 ‘S3’에서 벡터 저장소를 제공해 벡터 업로드, 저장, 쿼리 비용을 최대 90%까지 줄일 수 있다. 이 서비스는 처리량보다는 장기 저장과 드문 데이터 접근에 최적화된 성능과 비용 최적화된 데이터 기반을 제공한다. 피터 데산티스 수석부사장은 “S3 벡터의 사용이 빠르게 늘고 있고, 새로운 사용 사례가 등장할 것으로도 기대한다”고 언급했다.

이재성 트웰브랩스 대표는 이번 기조연설에서 아마존 베드록과 S3 벡터 서비스의 사용 사례를 소개했다. 트웰브랩스의 마렝고, 페가수스 모델은 베드록에서 제공되며, S3 벡터를 통해 대규모의 최적화된 비디오 인텔리전스를 비용 효율적으로 구현했다. 이재성 대표는 이 자리에서 “아마존 S3 벡터는 S3 버킷을 포텐셜 비디오 검색 엔진으로 바꿨다”고 언급했다.

AI 성능은 물론 효용성까지 챙긴 ‘트레이니움3’

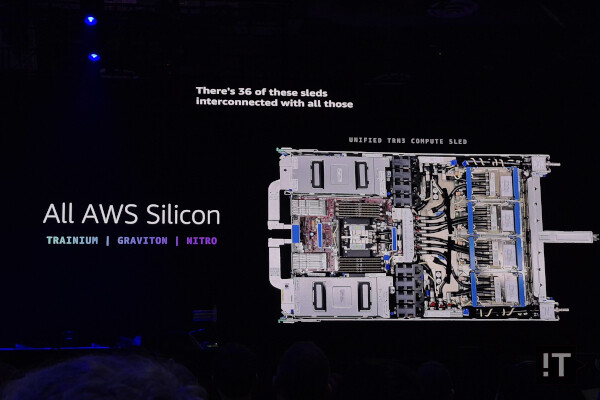

피터 데산티스 수석부사장은 ‘트레이니움3’ 칩에 대해 “훈련과 추론 작업 양 쪽 모두에 최적화됐고, 모든 AI 워크로드에 활용할 수 있다. 앤트로픽의 최신 모델에도 활용됐다”며 “성능도 뛰어나고, 까다로운 AI 워크로드에서도 40% 낮은 비용으로 사용할 수 있다”고 소개했다. 이 ‘트레이니움3’ 칩을 사용한 랙스케일 시스템인 ‘아마존 EC2 Trn3 울트라서버’도 이번 ‘리인벤트 2025’ 행사를 통해 공개됐다.

‘아마존 EC2 Trn3 울트라서버’는 최대 144개의 ‘트레이니움3’ 칩을 탑재하고, ‘뉴런 스위치’ 기반 고속 네트워크로 모든 트레이니움3 칩을 연결해 거대한 슈퍼컴퓨터처럼 구성했다. FP8 기준 연산 성능은 362페타플롭스(PFlops), 탑재된 HBM 용량은 20TB, 대역폭은 700TB/s에 이르며, 이전 세대 대비로는 연산 성능은 4.4배, 메모리 대역폭은 3.9배 증가했다. 또한 메가와트(MW)당 토큰 생산량은 이전 세대 대비 5배 높다고 언급됐다.

아마존 EC2 Trn3 울트라서버는 그래비톤 프로세서와 트레이니엄 가속기, 니트로(Nitro) 칩 등이 모두 들어가 AWS의 칩만으로 구성된 첫 시스템이기도 하다. ‘Trn3 울트라서버’의 각 슬레드에는 한 개의 그래비톤 프로세서와 4개의 트레이니움 3, 두 개의 니트로(Nitro) 기반 네트워크로 구성됐다. 시스템 디자인 측면에서는 모든 부품이 시스템 윗쪽으로 접근, 교체 가능해 생산과 유지보수에도 용이하다고 소개됐다.

주요 워크로드를 위한 최적화도 마이크로아키텍처 수준에서부터 적용됐다. 그리고 이러한 특징을 최대한 활용하기 위한 방법으로, 트레이니움의 ‘뉴런코어 ISA(Instruction set architecture)’에 직접 접근할 수 있는 API인 ‘뉴런 커널 인터페이스(Neuron Kernel Interface)’가 소개됐다. 또한 애플리케이션 최적화를 위한 프로파일링 툴 ‘뉴런 프로파일러’, 프로파일링 데이터를 쉽게 확인할 수 있게 해 주는 ‘뉴런 익스플로러’ 등 최적화 도구도 언급됐다.

좀 더 범용적인 프레임워크 레벨 지원에서는 트레이니움3의 파이토치(PyTorch) 네이티브 지원이 제공될 것이라 발표됐다. 이를 통해 기존 파이토치 기반 개발자가 코드의 가속기 정의를 바꾸는 것만으로 트레이니움3로 AI 워크로드를 실행할 수 있다. 피터 데산티스 수석부사장은 “기존 GPU 기반 코드에서 한 줄만 바꿔서 트레이니움3로 코드를 실행할 수 있어, 새 소프트웨어 환경을 배우지 않고도 바로 사용 가능하다”고 언급했다.

라스베이거스=권용만 기자

yongman.kwon@chosunbiz.com

1

1 2

2 3

3 4

4 5

5